컴퓨터 비전에서 자기 지도 학습(self-supervised learning)은 데이터의 시각적 표현을 강화하는 데 중요한 역할을 한다. 기존 방법은 이미지 변환을 활용해 학습하는데, 이를 통해 다양한 시각적 변화를 일반화하고 의미를 유지하는 데 초점을 맞췄다.

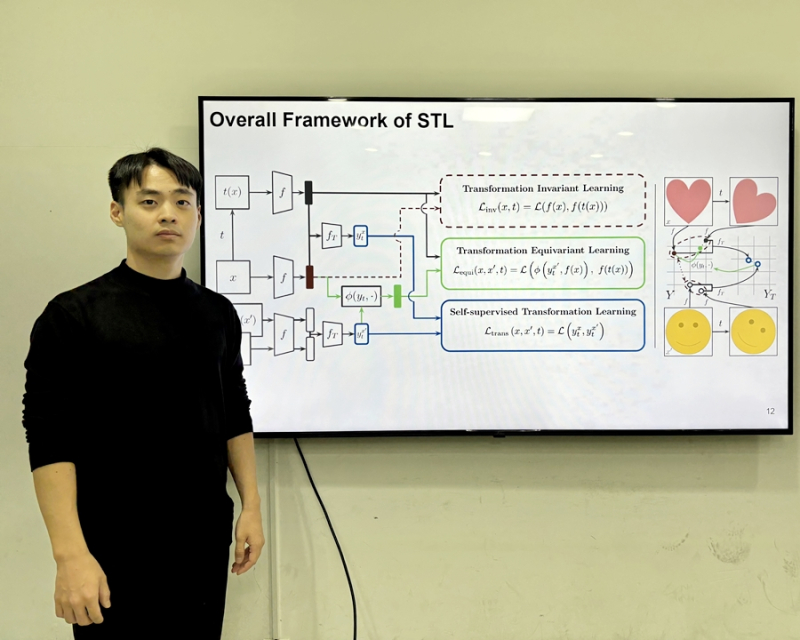

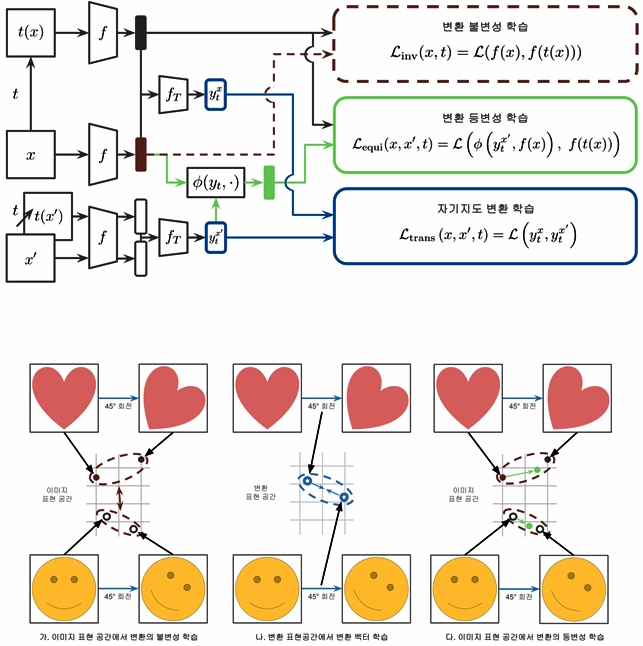

그러나 변환 불변 학습(transformation-invariant learning)은 변환 전후의 이미지 표현을 동일하게 만드는데, 이는 중요한 시각적 세부사항을 놓칠 가능성이 있어 세부적인 특징이 필요한 작업에는 한계가 있다.

변환 등변 학습(transformation-equivariant learning)은 이런 단점을 보완해 이미지 변환이 표현공간에서 동일하게 반영되도록 해 변환에 민감한 세부 정보를 유지할 수 있다.

인간처럼 인식하는 AI

KAIST 전기및전자공학부 김준모 교수 연구팀이 인간의 인지방식을 모방 이미지 변화를 이해하고, 시각적 일반화와 특정성을 동시에 확보하는 인공지능(AI) 기술을 개발했다.

이 기술은 의료영상 분석, 자율주행, 로보틱스 등 다양한 분야에서 이미지를 이해하고 객체를 분류·탐지하는 데 활용될 전망이다.

연구팀은 변환 레이블 없이 스스로 변환 민감 특징을 학습할 수 있는 새로운 시각 인공지능 모델 ‘STL(Self-supervised Transformation Learning)’을 제안했다.

이 STL은 스스로 이미지의 변화를 학습할 수 있고, 기존 방법론으로 학습한 모델이 이해할 수 없는 세부 특징까지 학습해 기존 방법보다 성능이 최대 42% 우수한 결과를 도출했다.

컴퓨터 비전에서 이미지 변환으로 데이터를 증강하는 강건한 시각표현 학습방식은 일반화 능력을 갖추는 데 효과적이다.

그러나 변환에 따른 세부사항을 무시하는 경향이 있어 범용 시각 AI 모델로서는 한계가 있다.

연구팀이 제안한 STL은 변환라벨 없이 정보를 학습할 수 있도록 설계된 새로운 학습 기법으로, 라벨 없이 변환 민감 특징을 학습할 수 있다.

또 기존 학습방법보다 복잡도를 유지한 채 효율적인 최적화화가 가능하다.

실제 STL은 정확하게 객체를 분류하고, 탐지실험에서 가장 낮은 오류를 기록했다.

아울러 STL이 생성한 표현공간은 변환의 강도와 유형에 따라 명확히 군집화돼 변환 간 관계를 잘 반영했다.

STL은 기반 모델에 독립적인 프레임워크로 기존 모델에도 광범위하게 적용할 수 있어 향후 의료영상 분석, 자율 주행, 로보틱스 등 다양한 분야에서 활용될 수 있다.

김 교수는 "이번에 개발한 STL은 복잡한 변환패턴을 학습하고 이를 표현 공간에 효과적으로 반영하는 능력을 갖춰 변환 민감 특징 학습의 새로운 가능성을 제시했다”며 "라벨 없이도 변환정보를 학습할 수 있는 기술은 다양한 AI 응용분야에 핵심 역할을 할 것으로 기대된다“고 말했다.

한편, 이번 연구는 KAIST 전기및전자공학부 유재명 박사과정이 제1저자로 참여했고, 연구결과는 국제학술지‘신경정보처리시스템학회(NeurIPS) 2024’에 발표될 예정이다. (논문명: Self-supervised Transformation Learning for Equivariant Representations)