곽노정 SK하이닉스 사장이 “기술을 공급하는 제조사를 넘어, 고객과 함께 미래를 설계하는 동반자가 되겠다”고 밝혔다. SK하이닉스는 이날 커스텀 HBM, AI-D(차세대 D램), AI-N(차세대 낸드)로 구성된 ‘뉴 메모리 솔루션’도 함께 공개하며 AI 추론 병목을 해소하겠다는 전략을 내놨다.

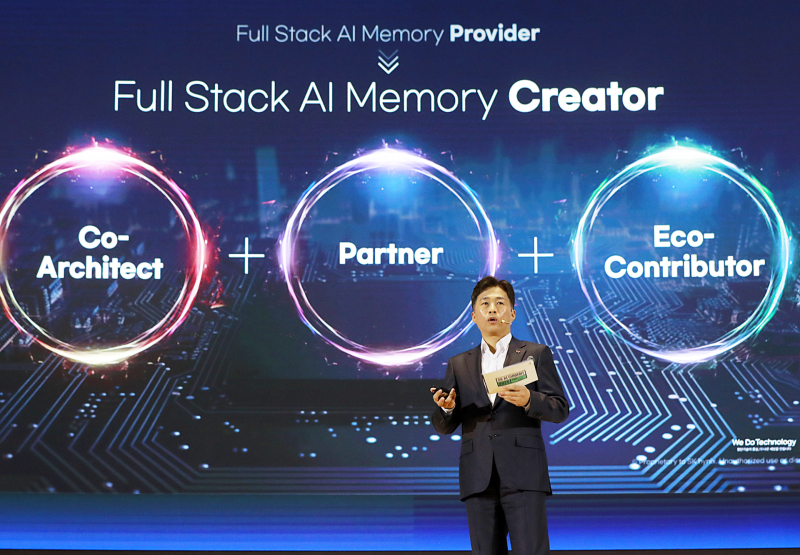

곽 사장은 3일 서울 강남구 코엑스에서 열린 ‘SK AI 서밋 2025’ 기조연설에서 “지금까지는 고객이 원하는 좋은 제품을 최적 시점에 공급하는 데 집중해왔다”며 “이제는 고객 문제를 함께 고민하고, 생태계와 소통하며 고객이 기대하는 것 이상을 제안하는 ‘풀스택 AI 메모리 크리에이터’로 진화하겠다”고 말했다.

특히 곽 사장은 AI 프로세서의 발전 속도에 메모리가 따라가지 못하는 이른바 ‘메모리 월’을 현시점 가장 큰 난제로 꼽았다. 그는 “메모리의 역할을 다변화하고 확장해 컴퓨팅 자원의 효율성을 높이겠다”고 강조했다.

이를 위한 해법으로 제시된 것이 △커스텀 HBM △AI-D △AI-N으로 구성된 ‘뉴 메모리 솔루션’이다. 커스텀 HBM은 그래픽처리장치(GPU)나 주문형반도체(ASIC)의 일부 연산 기능을 HBM의 베이스 다이로 옮겨 연산 성능과 에너지 효율을 동시에 높이는 방식이다.

AI-D는 용도별 맞춤형 D램으로, 총소유비용(TCO) 절감을 위한 저전력 D램, 초고용량 메모리, 로보틱스·모빌리티 등으로 활용처를 확대한 고품질 제품이 포함됐다.

AI-N은 차세대 낸드 라인업으로 △고속 입출력을 구현한 AI-N P △적층 기반 고대역폭 구조인 AI-N B △HDD 대체를 겨냥한 가성비형 AI-N D로 나뉜다.

이날 SK하이닉스는 차세대 HBM 로드맵도 처음으로 공식 발표했다. 2026년부터 △HBM4 16단 △HBM4E(8·12·16단) △커스텀 HBM4E를 순차 출시하고 2029년부터는 HBM5와 HBM5E 제품을 선보일 계획이다.

곽 사장은 “AI 추론 수요는 이제 성능뿐 아니라 총소유비용(TCO) 최적화로 확대되고 있다”며 “GPU에 있던 기능을 메모리로 옮겨 TCO를 낮추고, 효율을 극대화하는 제품을 만들 것”이라고 설명했다.

이러한 전략을 뒷받침할 글로벌 협업도 병행한다. 곽 사장은 “엔비디아와는 HBM 및 디지털 트윈 기반 AI 제조 혁신을 협의 중이고, 오픈AI와는 고성능 메모리 적용을 위한 장기 협력 가능성을 논의하고 있다”고 밝혔다.

이 외에도 TSMC와는 차세대 HBM 기술, 샌디스크와는 고대역폭 낸드(HBF) 국제 표준화, 네이버클라우드와는 데이터센터 최적화를 위한 메모리·소프트웨어 공동 개발을 추진 중이다.

곽 사장은 “지난 1년간 SK하이닉스는 글로벌 메모리 시장 1위로 도약했고, ‘일하고 싶은 기업 1위’로도 선정됐다”며 “고객과의 협업을 통해 기술, 사람, 생태계 모두에서 1위를 이어가겠다”고 밝혔다.