한국전자통신연구원(ETRI)이 초대형 인공지능(AI) 학습 과정에서 발생하는 고질적인 ‘메모리 부족’을 근본적으로 해결할 수 있는 핵심 기술 ‘옴니익스텐드(OmniXtend)’를 개발했다.

이 기술은 표준 네트워크 기술인 이더넷을 활용해 여러 서버와 가속기의 메모리를 하나처럼 공유해 향후 AI와 빅데이터 산업 인프라를 혁신할 것으로 기대된다.

최근 챗지피티(ChatGPT)와 같은 초대형 AI 모델 수요가 급격히 늘면서 처리해야 할 데이터 규모도 폭발적으로 커지고 있다.

하지만 연산 장치인 그래픽처리장치(GPU) 성능이 아무리 좋아져도 데이터를 담을 메모리 용량이 부족하면 전체 연산 효율이 급격히 떨어지는 ‘메모리 장벽(memory wall)’ 문제가 발생한다.

표준 이더넷으로 메모리 경계 허물어

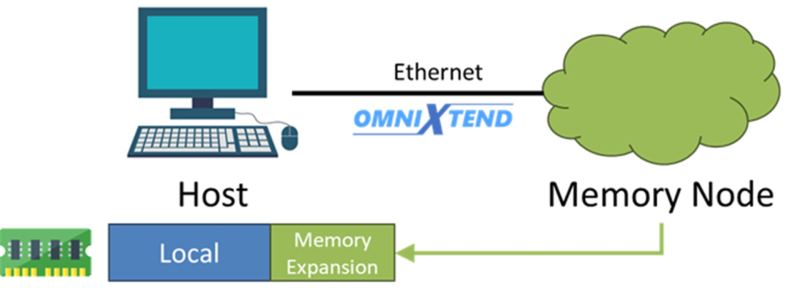

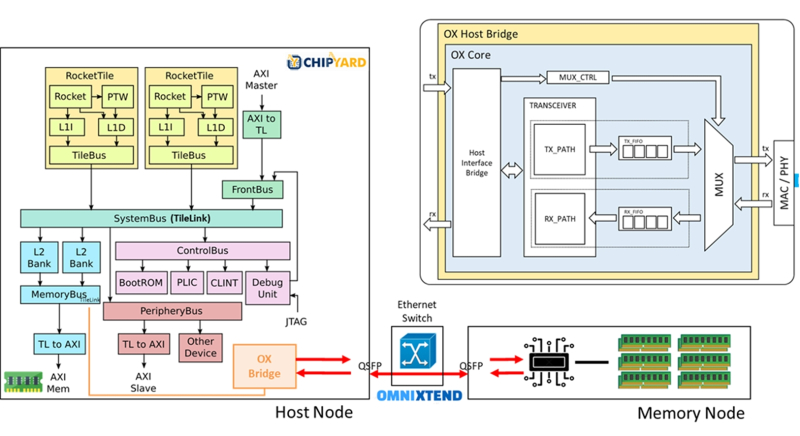

ETRI가 개발한 옴니익스텐드는 각 장비에 개별적으로 흩어져 있던 메모리를 네트워크 전반으로 확장해 하나의 대용량 메모리처럼 사용하는 기술이다.

기존 고속 직렬 통신 인터페이스(PCIe) 방식은 장비 간 연결 거리와 확장성에 한계가 있었다.

반면 옴니익스텐드는 데이터센터에서 흔히 쓰는 이더넷 스위치를 활용해 물리적으로 떨어진 다수의 장비를 하나의 ‘메모리 풀(pool)’로 묶을 수 있다.

이 기술은 메모리를 필요한 만큼 유연하게 확보할 수 있는 구조를 갖춰 초대규모 AI 환경에 최적화했다는 평가를 받는다.

특히 서버를 통째로 교체하지 않고도 메모리만 확장할 수 있어 데이터센터 구축과 운영 비용을 크게 줄이는 효과가 있다.

AI 모델 추론 성능 2배 이상 회복

연구진은 현장 프로그래밍 가능 게이트 어레이(FPGA) 기반 메모리 확장 노드와 이더넷 기반 메모리 전송 엔진 등 핵심 기술을 개발해 시스템 안정성을 검증했다.

실제 대규모 언어 모델(LLM)을 활용한 테스트 결과 메모리 용량이 부족해 성능이 떨어졌던 환경에서 옴니익스텐드를 적용하자 처리 성능이 2배 이상 회복하는 것을 확인했다.

이는 메모리가 충분한 기존 환경과 비슷한 수준의 성능을 유지할 수 있음을 의미한다.

ETRI는 지난해 프랑스 파리와 미국 산타클라라에서 열린 ‘RISC-V 서밋’에서 해당 기술을 연이어 공개하며 글로벌 기술력을 입증했다.

또 리눅스 재단 산하 칩 설계 협의체인 ‘칩스 얼라이언스(CHIPS Alliance)’에서 인터커넥트 워킹 그룹을 주도하며 국제 표준 정립에도 힘쓰고 있다.

ETRI는 이 기술을 차량·선박 등 고신뢰 임베디드 시스템과 이종 가속기 간 메모리 공유 구조 고도화 등에 적용하기 위한 후속 연구를 이어갈 방침이다.

김강호 ETRI 초성능컴퓨팅연구본부장은 “향후 신경망처리장치(NPU)와 가속기 중심 메모리 연결 기술 연구를 본격 확대할 계획”이라며 “글로벌 기업의 차세대 시스템에 이 기술이 적용될 수 있도록 국제 협력을 지속하겠다”고 말했다.

한편, 이번 연구는 과학기술정보통신부와 정보통신기획평가원(IITP)의 ‘메모리 중심 차세대 컴퓨팅 시스템 구조 연구’ 과제 일환으로 수행했다.